Har du någonsin träffat en person på gatan som skulle vara en till en som du? Kläder, ansikte, gång, kommunikationssätt, vanor är helt identiska med din. Det är som att skannas och skrivas ut på en skrivare. Låter lite läskigt, eller hur? Föreställ dig nu att du har sett en video där en sådan person berättar något om sig själv. I bästa fall kommer du att försöka komma ihåg när du promenerade på ett sådant sätt att du inte kom ihåg något, men du kan säga detta på kameran. Allt detta låter som enkelt resonemang, men tekniken är redan mycket nära att skapa sådana människor. De finns redan, men snart kommer det att finnas många fler.

Var kommer förfalskningen ifrån?

Nu finns det redan för många saker som ofta kallas förfalskningar. De är överallt. De finns på fotografier, i nyheterna, i produktionen av varor och i informationstjänster. Det är lättare att säga där det inte finns några fenomen som åtföljs av detta ord. Medan du kan slåss mot dem. Du kan studera bildens ursprung, kontrollera särdragen hos en märkesvaror från ett falskt och dubbelkontrollera nyheterna. Även om nyheter är ett separat ämne.

Numera vill en innehållskonsument inte vänta och kräver omedelbar produktion från sin skapare, ibland bryr han sig inte ens om kvaliteten, det viktigaste är att snabbt. Det är här situationer uppstår när någon sa något, och de andra, utan att kontrollera det, tog bort det från sina webbplatser och tidningar. I vissa fall tar det lång tid att snurra denna boll tillbaka och bevisa att det var fel.

Det finns ingen mening med att förklara varför detta är gjort. Å ena sidan finns det de som bara vill skratta av situationen, å andra sidan de som verkligen inte visste att de hade fel. En separat plats, ungefär i mitten, ockuperas av dem som det är trite för att vinna. Dessa kan vara intressanta för inflytande på olika nivåer, inklusive den politiska. Ibland är detta syftet med att göra vinst. Till exempel att så panik på aktiemarknaden och genomföra lönsamma transaktioner med värdepapper. Men ofta beror detta på fientlighet mot en person (företag, produkt osv.) För att minska honom. Ett enkelt exempel är att "släppa" i betyg av en film eller institution som inte är önskvärt för någon. Naturligtvis kräver detta en armé av dem som kommer att gå och ogilla (ibland även bots), men det är en annan historia.

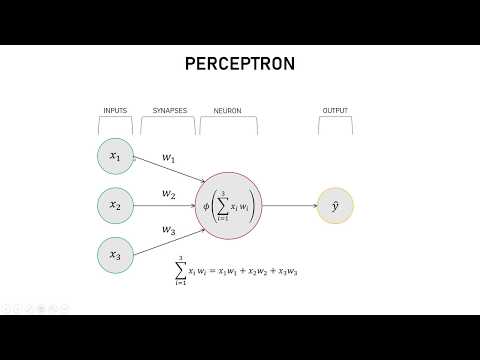

Vad är Deep Learning?

Kampanjvideo:

Nyligen låter denna term mer och mer ofta. Ibland är han inte ens släkt med ärendet och förväxlas med något annat. Så mjukvaruprodukten ser mer imponerande ut.

Tror inte att begreppet och grundläggande principer för maskininlärning dök upp för bara några år sedan. Faktum är att de är så många år gamla att många av oss inte ens föddes då. De grundläggande principerna för djupa inlärningssystem och de matematiska modellerna för deras arbete var kända sedan 80-talet av förra seklet.

På den tiden var det inte så mycket vettigt på grund av bristen på en viktig komponent. Det var hög datorkraft. Först i mitten av 2000-talet dök det upp system som kan hjälpa till att arbeta i denna riktning och göra det möjligt att beräkna all nödvändig information. Nu har maskiner utvecklats ännu mer och vissa system för maskinsyn, röstuppfattning och vissa andra fungerar så effektivt att de ibland till och med överträffar en persons kapacitet. Även om de ännu inte "fängslas" i ansvarsfulla riktningar, vilket gör dem till ett tillägg till mänskliga förmågor samtidigt som de behåller kontrollen över dem.

Vad är Deepfake? När dök Deepfake upp?

Det är lätt att gissa att Deepfake är ett litet stycke på ord som är associerade med Deep Learning och själva förfalskningarna som jag talade om ovan. Det vill säga Deepfake bör ta falska till en ny nivå och lossa en person i denna svåra verksamhet, så att de kan skapa falskt innehåll utan att slösa bort energi.

Först och främst gäller sådana förfalskningar video. Det vill säga att varje person kan sitta framför kameran, säga något, och hans ansikte kommer att ersättas med en annan person. Det ser läskigt ut, för faktiskt behöver du bara fånga en persons grundläggande rörelser och det är helt enkelt omöjligt att skilja en falsk. Låt oss se hur det hela började.

Det första generativa nätverksnätverket skapades av en student vid Stanford University. Det hände 2014 och studentens namn var Ian Goodfellow. I själva verket puttade han två neurala nätverk mot varandra, varav en var engagerad i generationen av mänskliga ansikten, och den andra analyserade dem och talade på liknande sätt eller inte. Så de tränade varandra och en dag började det andra nervnätverket bli förvirrat och ta de genererade bilderna på riktigt. Det är detta allt mer komplexa system som föder Deepfake.

Nu är en av de främsta promotorerna för Deepfake-idén Hao Li. Han gör inte bara detta utan också många andra. För detta tilldelades han upprepade gånger olika priser, inklusive inofficiella. Förresten, han är en av dem som bör tackas för uppkomsten av animoji i iPhone X. Om du är intresserad kan du bekanta dig med det mer detaljerat på hans webbplats. Idag är han inte det huvudsakliga diskussionsämnet.

Vi kom bara ihåg honom för att han visade sin ansökan på World Economic Forum i Davos, vilket gör att du kan byta ut ansiktet på en person som sitter framför kameran med något annat ansikte. I synnerhet visade han hur systemet fungerar på exemplet med ansikten till Leonardo DiCaprio, Will Smith och andra kända personer.

Det ser lite läskigt ut. Å ena sidan kan du bara beundra den moderna tekniken som låter dig skanna ett ansikte, ändra det till ett annat när du är på språng och producera en ny bild. Allt detta tar en sekund och systemet bromsar inte ens ner. Det vill säga, det tillåter inte bara att bearbeta den färdiga videon och ersätta ansiktet, utan också att delta i en sådan karaktär i någon form av livevideokommunikation.

Fara för Deepfake. Hur ändrar jag ansiktet på en video?

Du kan prata så mycket du vill att den här tekniken behövs, den är väldigt cool och att du inte behöver förtala. Du kan till och med gå till det yttersta och börja säga att detta är ställningen för en hård oldfag som helt enkelt är rädd för allt nytt, men det finns verkligen fler faror än fördelar.

Med sådan teknik, särskilt om det är open source, kan alla surfa och spela in alla videor. Det är inte illa om det bara fördömer någons ära och värdighet, mycket värre om det är ett uttalande som gjorts på uppdrag av en viktig person. Genom att spela in en video som bara är 30-40 sekunder lång på Tim Cooks vägnar kan du ta ner nästan hela USA: s IT-sfär, ledd av Apple. Aktiemarknaden kommer att drabbas så hårt att den kommer att få panik bland investerare. Som ett resultat kommer tusentals människor att förlora miljarder dollar.

Den som inte gillar det här sättet att tjäna pengar kommer att säga att det är det de behöver, låt dem gå till anläggningen. Men under det sorgligaste scenariot kommer det inte att finnas någon växt efter detta. Dessutom är det känsligt att vi får en person som fuskar på fluktuationer i värdet på värdepapper. Det räcker bara att köpa och sälja dem i tid.

Situationen kan bli ännu värre om "jokern" uttalar sig på uppdrag av ledaren för en stor stat. Naturligtvis kommer allt att avslöjas, men under denna tid kan du göra en hel del obehagliga saker. Mot denna bakgrund, helt enkelt att ersätta en kändis ansikte med en skådespelare i en vuxen film skulle vara en oskyldig prank.

Med sådana tekniker är det viktigaste att skanna, och då är det en fråga om teknik. I ordets verkliga mening.

Du kan föreställa dig den motsatta situationen, när en riktig person säger något, och sedan försäkrar alla att han var inramad. Hur man är i den här situationen är inte heller mycket tydlig. Detta kommer att få en sådan förvirring till nyhetsflödena att det helt enkelt inte är möjligt att dubbelkontrollera det i en annan källa. Som ett resultat blir det generellt oklart vad som är sant och vad som är falskt i denna värld. En bild framträder från filmer om en dyster framtid, som Surrogates eller Terminator, där T-1000 presenterade sig själv som andra människor och bland annat kallade John Conor på uppdrag av sin adoptivmamma.

Nu talar jag inte ens om ett annat missbruk som gör det möjligt att samla in falska bevis. Mot denna bakgrund blir allt roligt med leksaken för tveksam.

Hur upptäcker Deepfake?

Problemet är inte ens att sådana system bör förbjudas, men att detta inte längre är möjligt. De är redan där, och utvecklingen av teknologier, inklusive läsning av ansikten, har lett till deras utseende och spridningen av öppen källkod. Även om vi föreställer oss att systemet i sin nuvarande form kommer att upphöra att existera, måste vi förstå att det skapas på nytt. De kommer bara en gång att lära neurala nätverk att arbeta med varandra och det är det.

Hittills är inte allt så skrämmande, och du kan bokstavligen identifiera en falsk med blotta ögat. Bilden är liknande, men ganska grov. Dessutom har hon ibland vissa blandningsproblem, speciellt runt ansiktet. Men ingenting står stilla och det är inte alls svårt att utveckla det ännu mer. Samma Hao Li är säker på att detta inte kommer att ta mer än några månader, och för att skapa "masker" som till och med en dator inte kan skilja, kommer det att ta flera år till. Efter det kommer det inte att vända tillbaka.

Å ena sidan kan algoritmen som YouTube och Facebook redan skapar skydda mot detta. Förresten, den senare öppnade till och med en tävling för utveckling av erkännande teknik - Deepfake Detection Challenge ("Uppgiften att upptäcka deepfakes"). Prisfonden för denna tävling är $ 10 miljoner. Tävlingen pågår redan och avslutas i mars 2020. Du kan fortfarande ha tid att delta.

Att ersätta ett ansikte i en video är inte längre ett problem.

Kanske denna generositet beror på en falsk video med Mark Zuckerberg själv. Om de två är släkt, är uppkomsten av en sådan tävling inte förvånande.

Om det utbytta ansiktet matchar originalen fullständigt kommer motkraften som representeras av ett speciellt neuralt nätverk att vara maktlös. I det här fallet måste hon fånga minimala skillnader i ansiktsuttryck, rörelser och sätt att prata. När det gäller kända personer kommer ett sådant problem att lösas på nivån för videotjänsten, eftersom samma YouTube vet hur den konventionella Donald Trump rör sig. När det gäller en mindre känd person blir det svårare. Även om detta också kan bevisas genom att placera honom framför kameran och ha en avslappnad konversation medan det neurala nätverket analyserar hans rörelser. Det kommer att visa sig vara något som att studera ett fingeravtryck, men som vi ser kan det återigen leda till onödiga svårigheter.

Syning av videoautentiseringssystem i kameror kan också kringgås. Du kan göra att kameran markerar den inspelade videon och tydliggör att den inte filmades genom en separat applikation eller behandlades i ett speciellt program. Men hur är det med videor som just har bearbetats? Till exempel en redigerad intervju. Som ett resultat kommer vi att få en video där den ursprungliga nyckeln inte längre kommer att vara.

Några memes i slutet.

Kan vi säga att vi nu har ritat ett av scenarierna för en mörk framtid? I allmänhet, ja. Om teknologierna som skapades för att uppnå goda mål kommer ut ur kontrollen, kan de smutta av sorg. Det finns faktiskt många alternativ för sådan farlig teknik, men de flesta av dem är skyddade. Till exempel kärnfusion. Här har vi att göra med kod som vem som helst kan få.

Skriv i kommentarerna hur du ser skydd mot förfalskning med tanke på att maskeringssystemet kunde göra masker helt identiska med de ursprungliga ansikten. Och eftersom de är på video kan du inte ens tillämpa djup- och volymigenkänning på dem. Låt oss dessutom anta att alla kod och nycklar som är inbäddade i bilden kan hackas. Som de säger, skulle det vara för vad. Nu kan vi diskutera, all introduktion finns där.

Artem Sutyagin